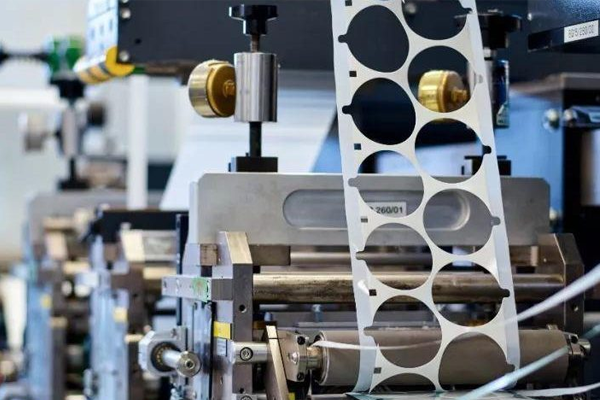

哎,您说说,现在这工厂里的机器人,干活是越来越“愣”了。让它去抓个零件,位置稍微偏一丁点,它要么抓个空,愣在那儿,要么“哐当”一下给你怼歪了。这哪是智能,分明是“智障”嘛!说到底,它缺的不是力气,是一双能看清、能算准的“慧眼”。这双“慧眼”的核心本事,就是咱们今天要唠的 工业相机坐标定位。说白了,它就是让相机不仅能拍照,还能告诉机器人“目标到底在哪儿”,把图像里的像素点,变成机器人能动、能抓的真实世界坐标-3。这门技术,如今可是智能生产线从“机械重复”走向“灵活智能”的命门。

不过,您可别以为这活儿简单,不就是拍个照、定个点嘛?里头的道道深了去了。首先一个老大难就是“手眼协调”。您想想,相机装在固定架子上(眼在手外),或者干脆装在机器人手臂上(眼在手上),它看到的坐标,和机器人自己理解的坐标,压根不是一码事-9。这就好比您用手机地图导航,地图说“目的地就在您正前方10米”,可您得先明白自己面朝哪、手机指南针准不准,才能迈开腿啊。为了解决这个“鸡同鸭讲”的问题,工程师们得进行复杂的“手眼标定”。最常见的就是用那个“九点标定法”,让机器人带着工具或相机,走一个九宫格的位置,在每个点拍照,一点点抠出相机坐标系和机器人坐标系之间的数学转换关系-6。这个过程,就像是给机器人和相机举办一场“联谊会”,让它们俩对好暗号,统一语言。

所以您看,实现精准的工业相机坐标定位,远不止买个好镜头那么简单。它是一套从物理安装就要开始精密筹划的系统工程。相机装多高、离工件多远,都大有讲究。离得太近,视野太小,看不全;离得太远,分辨率下降,精度不够。有专家打了个比方,这就像用相机拍月亮,距离决定了您能看到环形山还是模糊一片-5。更头疼的是环境光,车间里其他设备的反光,都可能让相机“眼花”,把亮斑当成零件边缘。真正的挑战在于,如何在变化的光线、不同的零件姿态、甚至表面有油污的情况下,依然能稳定、可靠地输出那个唯一的、正确的坐标。

光解决“看见”和“对齐”还不够,现代产线讲究速度,等不起。传统的法子是相机拍下高清大图,一股脑儿传给工控机,工控机吭哧吭哧算半天,再告诉机器人结果。这中间的传输和计算,都是时间。于是,技术的前沿就指向了“在相机里就把活儿干了”。这就引出了工业相机坐标定位的另一个关键进化:算法硬件化。比如,有些高端相机直接把“形状中心点查找”这类算法,烧录进相机内部的FPGA芯片里-2。相机拍到图像后,在传感器层面瞬间完成核心计算,只把最终的坐标值(比如X, Y, 角度)几个轻量级数据传出去-4。这么做的好处太大了!首先快,几乎没有延迟,真正实时;其次稳,不受电脑操作系统卡顿的影响;最后还省了工控机的大量算力-2。这就好比给相机不仅配了眼睛,还配了一个条件反射级的小脑,看到即判定,极度高效。

说到这里,咱得提提更高级的3D定位了。对于堆叠的零件、需要精准对孔的装配,只知道平面(X, Y)坐标可不行,还得有深度(Z)信息。这时候,3D工业相机就派上用场了。它通过激光扫描或结构光技术,能瞬间获得物体表面的“点云”数据——就是成千上万个带有三维坐标的点-7。基于这个,系统不仅能知道料口在哪,还能知道它的朝向,哪怕它是歪的,也能算出正确的中心位置,引导下料装置精准对接-7。这就从“平面视力”升级成了“立体视觉”,应对的场景复杂多了。

工业相机坐标定位这门技术,它静悄悄地藏在生产线的一个个工位里,却是智能制造的“感知基石”。它把混沌的物理世界,翻译成机器人能理解的精准数字坐标,让笨拙的机械臂拥有了柔性的灵魂。从2D到3D,从软件计算到硬件集成,它的每一点进步,都在让我们的工厂变得更聪明、更灵活。

1. 网友“精益求金”提问:看完文章很受启发,但我们是个小厂,预算有限。像文中提到的FPGA集成相机、3D相机这些,是不是都特别贵?有没有性价比高一点的方案,也能实现基本的定位引导?

答:“精益求金”朋友,您这个问题提得太实在了,绝对是大多数中小企业最关心的事儿。首先咱得把心放肚子里,绝不是所有高精度定位都得天价投入。技术的选择,完全取决于您的具体需求。

您如果只是做平面内的精确定位,比如传送带上抓取规则零件、对准装配,那么一套成熟的2D视觉系统就完全够用。它的核心是一台普通工业相机、镜头、光源,配上电脑里的视觉处理软件。关键在于做好我们文中提到的“手眼标定”,只要标定精准,达到0.1mm甚至更高的重复定位精度是完全可能的-3。这种方案硬件成本相对亲民,技术也最成熟。

那钱应该花在刀刃上的“刀刃”是哪儿呢?第一是稳定性,第二是易用性。

稳定性:车间环境震动、光线变化、电压波动都是杀手。与其追求相机像素的极限,不如投资一个好的工业光源(如环形光、条形光)和稳定的光源控制器,确保在任何时候打光效果一致,这能解决80%的图像质量问题。

易用性:很多国产的智能视觉软件(或一体式智能相机)现在做得很好,把复杂的标定、模板匹配工具都做成了图形化界面,像搭积木一样配置流程-1。这能极大节省您工程师的开发和调试时间,时间成本也是钱啊。

所以,咱小厂的策略可以是:用标准的2D硬件 + 成熟易用的软件包 + 精细的现场调试。先解决从无到有的问题,把流程跑通,效率提上来。等未来有更复杂的需求(如需要三维信息、速度要求极高)时,再考虑将部分工位升级为3D或带硬件加速的相机。起步阶段,扎实可靠远比追求技术炫酷更重要。

2. 网友“调试小王子”提问:我是产线上的设备调试员,最头疼的就是视觉这块老是调不好,今天准明天不准。标定到底怎么做才能一次做好,并且能保持长时间稳定?

答:“调试小王子”兄弟,您这问题可算问到根子上了!调视觉,确实是七分靠准备,两分靠手艺,一分靠运气。想让系统稳定,得像个老中医,系统性地调理。

首先,标定前的“准备工作”比标定本身还重要。 这就像盖楼打地基。

机械安装必须牢靠:相机、镜头、光源,所有支架必须锁死,杜绝任何微小的晃动或沉降。尤其是“眼在手上”的方案,机器人末端工具一定要装稳-9。

环境光要隔绝:尽量做防护罩,屏蔽掉窗户自然光和其他设备指示灯的变化干扰。确保主要光源是您自己控制的那个。

标定板要选对、放平:标定板的精度直接影响结果。把它放在与工件实际高度一致的平面上,并确保它与机器人基座或工具法兰是平行的(可用水平仪测),这个“平行”是后续计算准确的基础-6。

标定过程要“多点多姿态”采样。 别只在视野中心标一下。要充分利用机器人的运动空间,让标定板出现在相机视野的四个角和中部等多个位置,并且可以适当倾斜几个角度-6。采集的点位数据越多,标定算法计算出的转换关系就越能覆盖整个工作空间,抗误差能力越强。很多软件支持自动标定程序,可以编写脚本让机器人自动走位,这比手动点更精准高效-6。

标定后必须“验证与备份”。 标定完不是结束。要用一个或多个已知位置的测试工件,反复让视觉拍照并引导机器人去抓取或对准,实测其重复精度。如果发现某个区域偏差大,就要在那个区域补充标定点。一切OK后,务必将标定参数文件、当时的环境参数(如光源亮度、相机参数)全套备份。未来一旦不准,可以先恢复这套参数,快速排查是机械变了,还是光环境变了,抑或是视觉参数被误改了。

记住,稳定的视觉系统是“调”出来的,更是“养”出来的。定期检查、预防性维护,比出了问题再救火要省心得多。

3. 网友“未来观察者”提问:现在AI和深度学习这么火,它会对传统的工业相机坐标定位技术产生颠覆吗?未来的趋势会是怎样的?

答:“未来观察者”朋友,您这视角非常前沿。AI深度学习确实给机器视觉带来了震撼,但说“颠覆”传统定位技术可能还为时过早,更准确的词是 “深度融合”与“赋能升级”。

目前,传统几何视觉定位(基于特征匹配、轮廓提取)和深度学习,正在形成明确的职责分工。传统的定位方法,在零件特征明显、环境可控的场景下,速度快、精度高、确定性极强,依然是高节拍产线上的主力。而深度学习,更擅长处理传统方法棘手的难题:比如零件堆叠严重互相遮挡、形状极不规则、表面纹理变化大(如铸件)、或需要从一堆杂乱的背景中识别出目标。AI可以作为一个强大的“前置过滤器”或“分类器”,先找到目标大概在哪、是哪种零件,然后再交由传统的精确定位算法去计算亚像素级的精确坐标和角度。

未来的趋势,我认为会走向 “端-边-云协同”的智能感知:

“端”(设备端):就是文中提到的FPGA集成算法,负责完成最底层、要求实时性的确定性任务,如坐标提取、简单测量-2-4。

“边”(边缘服务器):在产线旁的工控机或服务器上,运行更复杂的深度学习模型,处理多个相机的信息,进行更高级的识别、缺陷检测和初步决策。

“云”:负责收集全厂数据,训练和优化AI模型,再将优化后的模型下发到边缘和终端。

所以,工业相机坐标定位的未来,不会是单一技术的替代,而是一个多技术融合的、分层化的智能系统。相机本身会更“聪明”(内置基础AI功能),它与机器人、生产管理系统(MES)的联结会更紧密。最终目标不仅是“定得准”,更是能“理解”场景,自适应变化,实现真正的柔性生产。