你是不是也遇到过这种憋屈事儿:花大价钱上了套高端工业相机,满心指望它能在产线上大杀四方,结果用起来却各种“水土不服”——检测时快时慢、良品率波动大、时不时还给你丢帧报个错。最后生产主管跑来质问,你只能挠着头说:“设备…设备可能不太行。” 先别急着让硬件背锅!很多时候,问题真不在那块冰冷的镜头上,而在于你怎么去“驯服”它。说白了,工业相机软件优化分析这门功课做没做到位,直接决定了你的投资是买了台“显微镜”还是“玩具镜”-1。

很多人以为工业相机跟手机摄像头似的,插上就能使。这可是天大的误会。工业场景复杂得很:光照条件可能变、产品型号天天换、传送带速度还不一样。一套固定的参数包打天下?不存在的。有数据显示,超过67%的视觉系统故障,根源其实出在图像采集阶段的参数不匹配或状态切换延迟上-7。软件没调好,再牛的相机也抓瞎。

举个例子,最常见的“丢帧”问题。画面卡顿、数据丢失,你以为换根更贵的相机线就能解决?其实根子可能在软件和系统配置里。原因无非三个:一是相机内部的缓存不够,来不及处理;二是你用的视觉软件太“笨”,缓存机制不智能;三是你工控机的“驱动程序”拖了后腿,系统资源被瓜分-3。不进行细致的工业相机软件优化分析,你就只能在这些表面问题上打转,治标不治本。

想把相机潜力榨干,你得像老中医一样,学会“望闻问切”,从里到外系统性地调。

第一板斧:采集参数,别当“差不多先生”

图像采集是第一步,也是根基。这里面的门道,讲究一个“平衡”。

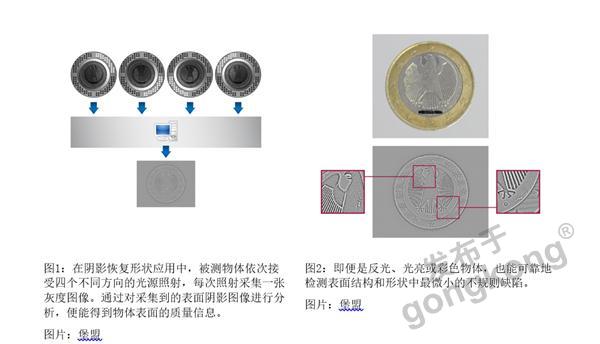

曝光时间是命门:图快,就把曝光时间拼命缩短?结果图像一片漆黑或者噪点爆炸,算法再牛也识别不了。正确的做法是,在保证图像质量稳定的前提下,尽可能减少曝光次数和时间-2。对于金属反光件这种“硬茬”,可能需要设两到三组不同的曝光时间拍照,信息才够-4。反之,对纸箱这种平整目标,果断减少曝光次数才是提速正道。

ROI(感兴趣区域)是神器:别让相机处理整个画面!用软件框出只包含目标工件的区域,把没用的背景统统丢掉。这能大幅减少数据量,缩短处理时间-2-4。就像让你在足球场上找一个人,和告诉你这个人在某个5平米的小房间里找,难度天差地别。

固件和驱动,勤更新:相机厂商可没闲着,他们会持续优化软件和固件来提升采集速度和图像生成效率。养成习惯,定期检查更新,这往往是“免费”的性能提升-2。

第二板斧:软件算法,从“看见”到“看懂”的进化

图像采回来了,怎么从中提取信息,就看软件的“内功”了。现在的趋势是“AI+规则”双剑合璧-1。

规则算法稳:像定位、测量这些传统任务,规则算法精度高、速度快,是产线上的“定海神针”。

AI算法灵:遇到产品迭代快、缺陷五花八门(比如背景杂乱、低对比度、有遮挡)的情况,深度学习模型就派上用场了。它能让系统自己学习特征,适应新场景-1。比如最新的算法平台,已经能让复杂场景下的找线成功率高达99.99%,还能用CPU推理,不用你额外花钱升级显卡-1。

处理流程要精简:软件里每一步处理都要时间。点云太密?用“降采样”简化它-4。每次都要匹配几十个工件?适当减少单次匹配数量,或者用“一拍多抓”的策略,拍一次照让机器人连续抓多个箱子,效率翻倍-2-4。记住一个原则:每一步操作,都要问自己是不是必需的。

第三板斧:系统协同,告别“机器人等相机”的尴尬

相机和软件再快,如果机器人闲着等结果,整体节拍还是上不去。真正的工业相机软件优化分析,必须站在整个自动化系统的维度看问题。

“即拍即走”是王道:高手怎么干?设置成相机一曝光完,机器人立刻就能动,视觉处理在机器人移动过程中后台悄悄进行-2。这能极大减少机器人的空闲等待。有案例通过优化,让图像采集延迟下降了近四成-7。

软硬兼施提性能:视觉处理是计算大户,工控机性能不能抠门。同时,机器人本体的路径也要优化:减少不必要的旋转、规划更平滑的移动轨迹、简化夹具和环境的3D模型以减少碰撞计算量,都能省下宝贵的时间-2-4。

调好现有系统很重要,但眼光还得放长远。工业相机软件优化的前沿,正发生两个深刻变化:

一是 “软件定义”与边缘智能。相机不再只是个采集图像的“眼睛”,更是一个带大脑的“智能传感器”。比如新型3D相机,直接在机内集成强大的CPU和AI处理单元,能在边缘端实时完成识别和决策,彻底摆脱了对昂贵外置工控机和复杂布线的依赖,还把单价打到了非常亲民的水平-9。这意味着,优化越来越前置,软件的权重越来越高。

二是 仿真与协同设计。以后搞方案可能不用反复折腾实物了。已有研究提出,可以在虚拟环境中,根据具体的视觉任务(比如检测某种特定瑕疵),反向模拟和优化相机参数(如镜头、传感器等),从而实现软硬件的“联合调优”,效率提升几十倍-6。这简直就是为工业相机软件优化分析插上了想象的翅膀。

说到底,工业相机不是个孤立的产品,它是一个需要精心调试的“系统核心”。把它买回来只是开始,持续的软件优化、算法迭代和系统磨合,才是让它真正创造价值的关键。别总抱怨设备不行,有时候,只是你的打开方式不对。沉下心,从参数、算法、协同三个层面做好工业相机软件优化分析,你会发现,那台被你嫌弃的相机,居然还能再战三年。

以下是三位网友的提问和回答:

网友“精益生产王工”提问:

老师讲得很实在!我们厂里正好有条检测线节拍不达标,老板天天催。文中提到的“即拍即走”我们很想试,但具体在Mech-Viz或类似软件里,这个“曝光完成信号”到底怎么发给机器人?会不会很复杂,要写很多代码?

回答:

王工,别担心,这个功能在成熟的视觉软件里通常已经模块化了,不需要你从零写代码,关键在于理解和配置正确的通信流程。我以常见的设置为例,给你拆解一下:

首先,核心思想是打破“拍照->处理->全部完成->机器人再动”这个顺序,变成“拍照->(立刻告诉机器人:拍完了,你先动)->后台同时处理图像->把结果发给正在移动的机器人”。这里的关键触发器,就是“曝光完成信号”。

在Mech-Vision这类软件中,通常有两种典型实现方式:

利用标准通信接口的状态码:这是比较通用和标准的方法。你在Mech-Vision工程的通信设置里,可以找到一个选项,比如 “勾选‘拍照完成再返回1102:触发成功’” -2。1102就是一个状态码。通常流程是:机器人发送触发信号给视觉系统,视觉系统启动工程,控制相机拍照。一旦相机曝光真正结束(注意,不是整个处理结束),软件就会立即向机器人返回这个“1102:触发成功”的信号。机器人PLC程序里,只要收到这个特定信号,就可以立刻开始移出拍照位,不用干等着。整个视觉处理在后台并行运行,等机器人运动到合适位置,再通过另一个接口(如Socket)去获取最终的处理结果(如坐标位姿)。

使用软件内部的“通知”或“发送信号”步骤:更直观一些。你可以在Mech-Vision的流程编辑里,在相机采集步骤之后,紧接着插入一个 “通知”或“发送数字输出”步骤-2。把这个步骤的输出,关联到机器人的某个数字输入(DI)端口上。这样,一旦流程执行到这个步骤,就会置位那个DI信号。机器人的程序里,就做一个简单的逻辑:触发拍照后,等待这个特定的DI信号变为高电平,一旦变成高电平,立即开始移动。

听起来复杂,但操作界面往往是图形化的。你需要做的其实就是:第一,在视觉软件里找到并启用这个功能(勾选选项或拖入步骤);第二,在机器人示教器里,修改一下等待逻辑,把之前“等待视觉结果返回”的条件,改成“等待曝光完成信号”;第三,可能需要在双方的程序里约定好信号地址或状态码编号。强烈建议先在一个简单的测试工程里验证这个逻辑,成功后应用到产线。这样做下来,节拍提升效果会非常显著,尤其是对于移动路径较长的场景。

网友“控制工程小白”提问:

大佬,文章里提到“AI+规则”融合,还有“边缘AI相机”-1-9。对我们中小企业来说,上AI是不是成本太高了?有没有一种折中的、能逐步升级的方案?比如我先用传统算法,以后再慢慢加AI?

回答:

小白同学这个问题问得非常实际,也是很多工厂的痛点。放心,现在行业的发展恰恰在解决这个“高不可攀”的问题,路径非常灵活,完全可以从轻量级入手。

首先,成本门槛已大幅降低。你提到的“边缘AI相机”就是个好例子。以前做AI检测,往往需要一台配备高端GPU的工控机,成本动辄上万。现在像LIPSedge S315这种相机,直接把相当于一个微型电脑(四核CPU+专用AI芯片)塞进了相机里,单价可以做到几百美金-9。这意味着,你单点上一个AI视觉站,硬件总成本可能比传统的“普通相机+高端工控机”方案还低,而且布线简单、稳定性更好。

“AI+规则”本身就是渐进式路径。你完全不必一开始就追求全AI检测。一个非常务实的策略是 “规则为主,AI为辅,逐步渗透” :

初级阶段(规则主导):用稳定的规则算法处理定位、测量、二维码读取等成熟任务。这些任务算法库非常丰富,上手快。

进阶阶段(AI补位):当遇到规则算法搞不定的“疑难杂症”时,再引入AI。比如,产品有个非常不规则的划伤,形状颜色多变,传统阈值分割和Blob分析总调不好。这时候,你可以只对这个“划伤检测”环节,训练一个小的、专用的深度学习模型(很多视觉软件都提供拖拽式的模型训练工具)。这个模型可以只部署在工控机甚至边缘相机里,专门处理这一小步。这样,整体方案成本可控,风险也低。

未来升级(AI增强):随着数据积累,你可以把AI应用到更多环节,比如用AI做更鲁棒的定位(应对遮挡、模糊),或者用AI直接做最终的质量分类。一些先进的算法平台,其工具已经内置了“AI+规则”的融合能力,同一个定位工具,既可以用传统几何特征,也可以调用深度学习特征,切换可能就是一个复选框的区别-1。

所以,给你的建议是:规划方案时,选择那些支持“软硬解耦”和“算法可扩展”的平台。硬件(特别是相机)最好能支持未来的边缘计算升级;软件平台要既能用传统工具,也方便接入AI模型。这样,你就可以用一个入门级的投入启动项目,随着产线需求和自身技术能力的增长,像拼乐高一样,灵活地增加AI模块,实现平滑升级。

网友“遭遇卡顿的技术员”提问:

老师,我们系统运行久了就会变卡,重启软件就好一阵。排查了不是网络和硬件散热问题。文中说“关闭调试输出”-2能提速,这个影响大吗?还有哪些类似的不起眼但很耗资源的软件设置?

回答:

技术员兄弟,你遇到的这个问题非常典型,就是典型的“软件隐性资源消耗”导致的性能衰减。关闭调试输出,效果可能比你想象的要大得多,尤其是在长时间连续运行时。

调试输出(比如在图像上实时画出检测框、显示中间处理图像、打印大量日志到界面)是为了方便工程师开发和调试。但这些可视化渲染和日志写入操作,会持续占用CPU和GPU资源,尤其是GPU的图形渲染资源。在部署运行时,这些花哨的功能完全没用,却像一个一直在后台运行的游戏,白白消耗算力。关闭后,通常能给视觉处理循环节省5%-15%的时间,更重要的是,能减少内存和显存的波动,让系统运行更稳定。

除了这个,还有几个“低调的性能杀手”值得你检查:

图像缓存与队列设置:很多视觉软件有图像缓存队列,防止丢帧。但如果队列设置过长(比如设置了100帧缓存),而你的处理速度偶尔波动,就会导致队列里堆积大量未处理的图像,占用巨量内存(一张高分辨率彩色图可能就几十MB),最终可能引起内存不足而卡顿甚至崩溃。合理设置缓存大小(通常是2-5帧),并开启“丢帧”策略来处理极端情况,比无限制缓存更稳定。

不必要的高分辨率采集与处理:你是不是用相机最高分辨率采集,然后在软件里第一步就缩小?这浪费了带宽和初始处理时间。直接在采集端设置到你实际需要的分辨率(ROI),是最高效的。

软件自身的日志级别:检查一下软件的日志记录级别。如果设置为“Debug”或“Trace”,它会记录每一次函数调用、每一个变量的变化,写入速度极快,对硬盘I/O和CPU都是巨大负担。在生产线运行时,务必把日志级别调到“Warning”或“Error”,只记录关键错误。

杀毒软件或系统更新的实时扫描:确保你的工控机上,将视觉软件的工作目录、数据存储目录以及可执行程序,都添加到杀毒软件的信任列表或排除列表里。否则,杀毒软件会不断扫描视觉软件生成和读写的每一个图像文件、每一个临时数据,造成严重的I/O延迟和卡顿-5。

工具链的冗余计算:检查一下流程里有没有重复计算。比如,同一个图像,被两个并行的分支流程重复进行了一模一样的预处理(如滤波、灰度化)。应该优化流程,让预处理只做一次,结果分发给后续分支。

建议你做一个对比测试:在产线需要重启前,记录下工控机的CPU、内存、GPU显存占用率。在维护时段,按照上述几点清理配置(关调试、调日志、查缓存、设信任列表),再重启软件运行。对比一段时间后的资源占用情况,你会发现显著改善。系统级的调优,往往就藏在这些细节里。